薛澜(来源:中国发展高层论坛 2024)

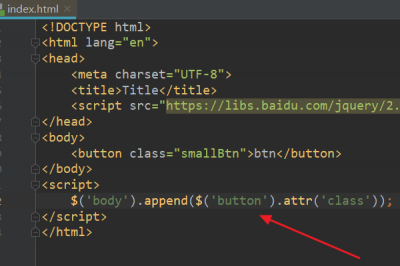

4 月 1 日消息,近期举行的中国数字经济发展和治理学术年会(2024)上,清华大学苏世民书院院长、人工智能国际治理研究院院长薛澜教授以《人工智能发展的治理挑战》为题进行了主旨演讲。

薛澜在演讲中表示,中国 AI 最新发展态势基本平稳,现在国内有超过 130 个大模型。尽管单从量上讲进步很大,但实际上中国大模型还存在不少问题。他提到有不少大模型是用“套壳”和拼装的方式构建的,而且算力也被“卡脖子”了。

“目前很多国外的模型是开源的,那么在开源的基础上进行套壳就可以形成一个套壳的大模型,接着再将一些这样的大模型拼装在一起就变成更大的大模型,这种方式做出来的大模型背后的原创性是有限的。另外,我们算力也被“卡脖子”,比如英伟达的 GPU A100 和 H100 被美国禁售,很多公司受到影响。”薛澜表示,此外,中国数据质量比较低,没有真正产业化,相对标准化的数据服务商还比较少,而且中国资本短视等,都是中国大模型产业下一步发展需要思考和解决的问题。

这是薛澜近期非常罕见地提及中国与美国 AI 大模型产业的一些套壳、算力、技术差距等问题。

薛澜表示,随着 2022 年 11 月份 ChatGPT 问世之后, AI 领域技术创新加速,尤其是以 OpenAI 为代表的美国技术前沿公司更是形成了你追我赶的局面。今年 OpenAI 推出了非常独特、跨模态的视频生成工具 Sora,时长可以达到 60 秒,惊艳全球,将对短视频等很多媒体娱乐行业产生巨大冲击。同时,自动驾驶、广告、教育、医疗、安防等不同领域也受到很大影响并有可能成为 Sora 潜在的应用市场。

“同时,美国在 AI 算力的核心硬件方面也有很多新突破,如 Groq LPU 这一新的大模型推理芯片,其制程虽然还是 14nm,但由于有 TSA 架构,使得其特定的处理能力非常快,推理速度比 GPU 快 10 倍,但能耗只是它的1/10。”薛澜称。

薛澜坦言,随着美国 Groq、英伟达、OpenAI 等公布多个 AI 新技术不断突破,进一步把中美大模型技术差距拉大,这对于中国的创新体系是一个很大的冲击。

”中国现在的创新模式还是遵循比较传统的线性模式,即从学术研究开始,到工程技术,最后再到产品。这个模式无法形成研究、工程和市场间密不可分的生态,这是现在中国创新体系亟待解决的问题。“薛澜表示。

薛澜指出,“中国 AI 的最新发展态势基本平稳,中国在 AI 领域发表论文全世界最多,美国是第二,中美合作的论文也很多。在 AI 大模型方面,现在已经超过 130 个大模型。如果单从量上讲进步很大,但是实际上我们的大模型还存在不少问题,因为有不少是用套壳和拼装的方式构建的。而且,我们的算力也被‘卡脖子’。

同时,中国数据质量比较低也是一个问题。中国的数据量很大,但没有真正产业化,相对标准化的数据服务商还比较少,因为大数据服务不赚钱,公共数据企业没有意愿去清洗,定制化服务又一般收费比较高。因此,数据市场如何构建也是需要解决的问题。

另外就是资本短视。资本短视有各种各样的原因,其中一个原因是对中国资本市场政策不稳定的担心,另外就是商业化面临一些挑战等。所有这些都是中国大模型产业下一步发展需要思考和解决的问题。”

薛澜认为,从综合社会收益讲,生成式 AI 的渗透性非常强,对社会影响是全面的。对制造业来说,AI 有利于推动产业的数智化转型升级,在推进新质生产力和高质量发展方面潜力巨大。中国在这方面已经做了很多探索,例如,三一重工制造工厂应用 AI 技术后提高 185%,生产周期 30 天缩短到 7 天。同时,AI 在推动智力密集型的服务产业规模化方面也发挥了巨大作用。

但是,“AI 的潜在风险体现在多个层面。在个体层面,AI 可能引发算法歧视、知识产权争议、信息错误等问题,这与技术本身相关。应用和开发过程中也有问题,包括数据隐私保护、防范伪造等。目前我们比较关心的是这些直接的影响,但是社会层面还有一些更长远的大问题,如劳动力结构调整、产业结构调整等影响。同时,由于劳动力结构调整,可能对收入分配影响很大,从而加剧数字鸿沟、社会不公平等问题,这些都是需要慎重考虑的。另外大模型训练的能源消耗非常厉害,现在看来可能所增加的温室气体排放也是不能忽视的。有人估算,ChatGPT 在整个训练周期的碳排放量相当于开车到月亮再返回地球的总量。”薛澜表示。

薛澜认为,“在国家安全层面的问题同样让人担心,包括对社会稳定的影响,在军事上的应用等。”

“在更高层面的风险上,我们都非常关心的就是通用人工智能(AGI)会不会在哪一天不受人控制?会不会影响整个人类社会的生存?也就是硅基文明和碳基文明今后会有什么冲突?这个层面的风险是人类社会生存的风险。在这类问题上,ChatGPT 的出现影响了整个社会,尤其在技术领域,很多专家也开始高度关注这个问题。2020 年,当时一些技术领域的专家对提出 AI 治理还有不同看法,认为 AI 技术刚刚发展起来,谈治理太早了。除此之外,当时我们对所谓 AGI 的潜在风险还没有那么担心,但 ChatGPT 出来后变化就很大了。最近,我参与了一些著名 AI 技术专家和治理专家的共同努力,撰写一篇提交给《科学》(Science)的论文。这篇论文就指出,我们已经到了刻不容缓需要推动 AI 全球治理的阶段。这些技术专家之所以认为情况变了,就是因为 ChatGPT 的出现让他们认为 AGI 可能出现的时间要大大提前。”薛澜指出。

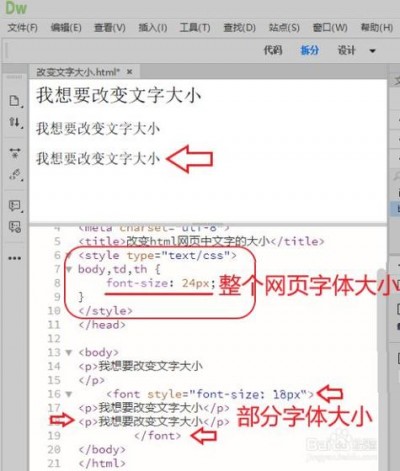

薛澜强调,AI 在电商、医疗、教育、科研等领域有很多应用,可能产生巨大的社会收益,但也会有很多风险,我们需要探讨怎么有效规避。技术本身产生的风险是典型案例。这里有个例子,当我们问 ChatGPT 北京清华大学校歌歌词是什么时,它会编造一个错误的答案,把北京大学和清华大学的一些信息混用。除此之外,还有数据滥用、隐私泄露、深度伪造等很多其他风险。再如在电商这一特定情境下,有些电商会做虚假宣传、大数据“杀熟”等。另外,未来 AI 领域的发展还需要综合考虑其社会效应,包括在塑造人类文明新形态的作用等。

薛澜坦言,从 2017 年的《新一代 AI 发展规划》开始,中国制定了三个阶段三步走的 AI 发展战略,AI 治理就是其中重要的内容,规划中明确提出关注 AI 的潜在风险、建设有效治理体系任务等。在 2020 年后,中国加快了 AI 治理步伐。

薛澜表示,中国的 AI 有雄厚积累与先发优势,形成了自上而下和自下而上相结合的治理框架,AI 技术也有非常广阔的应用场景,不过也要解决形成不同企业公平竞争市场环境、产业生态以及聚集全球顶尖 AI 人才等问题,推动 AI 产业健康有序发展。

除了上述言论外,薛澜最近还在“中国发展高层论坛 2024 年年会”人工智能发展与治理专题研讨会上表示,AI 治理有四大挑战,并建议加强国际合作、解决地缘政治问题。

薛澜认为,政策制定和科技发展步调不一致,造成 AI 治理的挑战。他指出,AI 的技术发展非常快,但治理体系的变化相对慢一些——一个法律法规要出台,其实要经过一系列的论证和各方面的考虑。

同时,政府端和企业端信息不对称,也给 AI 治理增加难度。传统的治理,是政府去治理和规制,而企业被规制,一般来讲是用“猫和老鼠”的游戏——企业要想办法去躲避政府的规制,政府要去挑企业的问题在哪里。但实际上,双方有很多盲区。企业不知道政府规制最关心的问题在哪儿,而技术发展可能会带来什么风险,政府也不清楚。所以双方的信息不对称,或者有时候共同无知的情况也经常出现。

此外,AI 治理的另一个挑战,是在风险规制的过程中的成本不对称。薛澜举例,滥用或误用 AI 的技术成本相当低,但要去防范这种风险非常困难,所需的成本要远远高于它有可能造成的危害。

最后一个挑战则来自全球治理。薛澜指出, AI 的治理是全球治理的问题,不是任何一个国家、任何一个国际组织或者一个企业独自能解决的。专业组织、国际组织、基金会、企业等组织都对这个问题有一定的治理兴趣,甚至于他们也有这方面的能力和条件,但是所有这些组织之间没有从属关系。

“联合国是不是最大的?但联合国可能管不了很多企业。中国政府管中国的企业有可能,但是管不了美国的企业,”薛澜指出,一系列机构互相之间有重叠、有矛盾还都有相关的利益,希望来参与治理,这样使得全球治理体系的形成就有很大的困难。

目前,全球政府均在完善生成式 AI 的监管。2023 年 8 月,七部门公布《生成式人工智能服务管理暂行办法》开始施行。美国白宫则在 2023 年 10 月发布 AI 监管令,最强大的 AI 系统的开发者在训练模型时必须通知联邦政府。2023 年 11 月,全球首届 AI 安全峰会在英国布莱切利园举办,中国、美国和欧盟在内的 28 个国家和地区签署了《布莱切利 AI 安全宣言》(Bletchley Declaration)。而在欧洲,《AI 法案》已在 2024 年 3 月生效。

对于前述四大挑战,薛澜提出一系列建议,包括要加强安全和技术研发,尤其要加强国际合作,同时鼓励企业的自我规制,学习国际民航业、核电站等行业的自我规制机制。

薛澜还特别提到地缘政治问题。他指出,美国国务卿布林肯把对华科技政策称为“小院高墙”,但在科技话题下,怎样才是真正的小院?薛澜提出,在 AI 领域,中美双方要加强合作,才能真正解决人类面临的各种问题。

2023 年,中国提出《全球人工智能治理倡议》,围绕 AI 发展、安全、治理三方面系统阐述了 AI 治理中国方案,包括主张建立 AI 风险等级测试评估体系,不断提升 AI 技术的安全性、可靠性、可控性、公平性;支持在充分尊重各国政策和实践基础上,形成具有广泛共识的全球 AI 治理框架和标准规范,支持在联合国框架下讨论成立国际 AI 治理机构等。

“总体来说,中国的 AI 有雄厚积累与先发优势,形成了推动 AI 发展的总体规划,在过去发展过程中也形成了自上而下和自下而上相结合的治理框架, AI 技术也有非常广阔的应用场景。同时,中国 AI 发展未来也面临着一些挑战。

首先是怎么样形成不同企业公平竞争的市场环境,包括民营企业、国有企业和外资企业、包括大中小企业等等,这种多元公平竞争的市场环境对 AI 领域发展至关重要;其次是产业生态问题,如何建立企业、资金、人才等多方面主体和多方面资源能够有效流通协调一致的产业生态。第三是治理问题,怎么形成可预期、包容审慎、敏捷有效的治理框架,为形成鼓励 AI 发展的市场环境和产业生态奠定制度基础;最后,就是怎么聚集全球顶尖 AI 人才,OpenAI 是全世界各国不同优秀人才聚集发展起来,人才多元化程度很高,中国在这方面需要加大开放力度。”薛澜坦言。

薛澜在演讲结尾强调,“在各方面的共同努力下,中国 AI 领域能够抓住发展机遇,克服重重困难,迎接多方面的挑战,有效防控各种风险,让 AI 的发展为中国现代化建设服务,为世界和平发展服务。”

(本文首发钛媒体 App,作者|林志佳、AI 科技组,编辑|胡润峰)

以下是薛澜在中国数字经济发展和治理学术年会(2024)的演讲全文:

从 2022 年 11 月份 ChatGPT 问世之后,人工智能领域技术创新加速,尤其是以 Open AI 为代表的美国技术前沿公司更是形成了你追我赶的局面。几个星期前 Open AI 推出了非常独特的,跨模态的视频生成工具 Sora,时长可以达到 60 秒,惊艳全球,将对短视频等很多媒体娱乐行业产生巨大冲击。同时,自动驾驶、广告、教育、医疗、安防等不同领域也受到很大影响并有可能成为 Sora 潜在的应用市场。

除此之外,在 AI 算力的核心硬件方面也有很多新突破,如 Groq LPU 这一新的大模型推理芯片,其制程虽然还是 14 纳米,但由于有 TSA 架构,使得其特定的处理能力非常快,推理速度比 GPU 快 10 倍,但能耗只是它的1/10。我国的芯片、GPU 等硬件本来就受到制约,现在美国在这方面的新突破把差距进一步拉大。这对中国的创新体系是一个很大的冲击。中国现在的创新模式还是遵循比较传统的线性模式,即从学术研究开始,到工程技术,最后再到产品。这个模式无法形成研究、工程和市场间密不可分的生态,这是现在中国创新体系亟待解决的问题。

中国人工智能的最新发展态势基本平稳,中国在人工智能领域发表论文全世界最多,美国是第二,中美合作的论文也很多。在 AI 大模型方面,去年 5 月我们已经发布了 79 个超过 10 亿的大模型,现在已经超过 130 个。如果单从量上讲进步很大,但是实际上我们的大模型还存在不少问题,因为有不少是用套壳和拼装的方式构建的。具体而言,目前很多国外的模型是开源的,那么在开源的基础上进行套壳就可以形成一个套壳的大模型,接着再将一些这样的大模型拼装在一起就变成更大的大模型,这种方式做出来的大模型背后的原创性是有限的。另外,我们的算力也被“卡脖子”,比如英伟达的 GPUA100 和 H100 被美国禁售,很多公司受到影响。同时,中国数据质量比较低也是一个问题。中国的数据量很大,但没有真正产业化,相对标准化的数据服务商还比较少,因为大数据服务不赚钱,公共数据企业没有意愿去清洗,定制化服务又一般收费比较高。因此,数据市场如何构建也是需要解决的问题。另外就是资本短视。资本短视有各种各样的原因,其中一个原因是对中国资本市场政策不稳定的担心,另外就是商业化面临一些挑战等。所有这些都是中国大模型产业下一步发展需要思考和解决的问题。

2018 年习近平总书记在中央政治局第九次集体学习中特别强调要加强人工智能发展潜在风险的研判和防范,确保人工智能安全可靠可控。2019 年和 2023 年又特别强调重视通用人工智能的发展,营造创新型生态,重视风险防范,综合考虑人工智能发展的社会收益和潜在风险两个方面。总书记的指示给我们推动人工智能创新发展和防控风险指明了方向。从综合社会收益讲,生成式人工智能的渗透性非常强,对社会影响是全面的。对制造业来说,AI 有利于推动产业的数智化转型升级,在推进新质生产力和高质量发展方面潜力巨大。中国在这方面已经做了很多探索,例如,三一重工制造工厂应用人工智能技术之后提高 185%,生产周期 30 天缩短到 7 天。同时,AI 在推动智力密集型的服务产业规模化方面也发挥了巨大作用。

人工智能的潜在风险体现在多个层面。在个体层面,AI 可能引发算法歧视、知识产权争议、信息错误等问题,这与技术本身相关。应用和开发过程中也有问题,包括数据隐私保护、防范伪造等。目前我们比较关心的是这些直接的影响,但是社会层面还有一些更长远的大问题,如劳动力结构调整、产业结构调整等影响。同时,由于劳动力结构调整,可能对收入分配影响很大,从而加剧数字鸿沟、社会不公平等问题,这些都是需要慎重考虑的。另外大模型训练的能源消耗非常厉害,现在看来可能所增加的温室气体排放也是不能忽视的。有人估算 ChatGPT 在整个训练周期的碳排放量相当于开车到月亮再返回地球的总量。在国家安全层面的问题同样让人担心,包括对社会稳定的影响,在军事上的应用等。去年 7 月基辛格到访中国,他非常关心的一个问题就是人工智能对国际安全的潜在影响,他提到二战以后全世界之所以能保持总体和平环境,很重要的一点就是因为国际社会形成了有效的核武器管控机制,这个机制基本保障了核武器没有大规模扩散。他认为未来人类社会如果还想继续保持安全,人工智能治理就应成为核心,而中美两国是全球人工智能治理最关键的国家。他非常积极地推动中美两国在这方面开展对话,后来我们也看到中美两国元首在旧金山的峰会上一致同意开展中美两国在人工智能领域的对话。

在更高层面的风险上,我们都非常关心的就是通用人工智能会不会在哪一天不受人控制?会不会影响整个人类社会的生存?也就是硅基文明和碳基文明今后会有什么冲突?这个层面的风险是人类社会生存的风险。在这类问题上,Chat-GPT 的出现影响了整个社会,尤其在技术领域,很多专家也开始高度关注这个问题。清华大学 2020 年成立了一个人工智能国际治理研究院,当时一些技术领域的专家对提出人工智能治理还有不同看法,认为人工智能技术刚刚发展起来,谈治理太早了。国际上同样也有这样的声音。这里有两方面原因,首先,是对“治理”这个概念有一定误解,大家只看到了治理概念中的规制一面。但治理包括两个方面,一方面是怎么更好地构建制度体系来推动良性发展,另一方面是规制的一面,如何减少技术发展可能给社会带来的风险及其损害。因此,治理对所有新技术的发展都是必要的。除此之外,当时我们对所谓通用人工智能的潜在风险还没有那么担心,但 Chat-GPT 出来后变化就很大了。最近,我参与了一些著名人工智能技术专家和治理专家的共同努力,撰写一篇提交给《科学》(Science)的论文。这篇论文就指出,我们已经到了刻不容缓需要推动人工智能全球治理的阶段。这些技术专家之所以认为情况变了,就是因为 Chat-GPT 的出现让他们认为通用人工智能可能出现的时间要大大提前。

除了刚刚谈到的几类综合性风险,我们更多要考虑具体应用场景。AI 在电商、医疗、教育、科研等领域有很多应用,可能产生巨大的社会收益,但也会有很多风险,我们需要探讨怎么有效规避。技术本身产生的风险是典型案例。这里有个例子,当我们问 ChatGPT 北京清华大学校歌歌词是什么时,它会编造一个错误的答案,把北京大学和清华大学的一些信息混用。除此之外,还有数据滥用、隐私泄露、深度伪造等很多其他风险。再如在电商这一特定情境下,有些电商会做虚假宣传、大数据杀熟等。除此之外,未来人工智能领域的发展还需要综合考虑其社会效应,包括在塑造人类文明新形态的作用等。

出于我刚刚提到的这些问题,人工智能治理受到全世界各国的高度关注,主要为美国、中国和欧盟。其中,欧盟在治理领域行动比较快,其出台的《通用数据保护条例(GDPR)》对世界各国影响很大,现在他们虽然在技术发展方面没有美国和中国走得快,但是在治理方面他们希望走在前列。大家知道,欧盟的人工智能法案已经通过,其定位和目标是通用性的法律,以保护人的基本权利为出发点。其特点是根据基本治理原则与不同的风险等级进行监管。风险被分成了 4 个等级,最高是不可接受风险,这是彻底禁止的,最低是轻微风险,这是可以合理存在的,而最让人关注的是中间的高风险和有限风险,高风险要严格规制。它把 Chat-GPT 定义为高风险系统,按照全生命周期进行监管,并采取相应的措施。

美国对人工智能的硬性监管要求不多,分联邦和州两个层面,主要目的还是鼓励市场建设,如透明化、反歧视等。州的层面出台了一些法律法规、联邦层面是去年 10 月拜登签署的《关于安全、可靠、可信地开发和使用人工智能的行政命令》,当时他还把人工智能领军企业的 CEO 请到白宫,要求他们承诺推动安全可靠可信的人工智能发展。

中国的人工智能发展战略很早就有考虑。2017 年出台的《新一代人工智能发展规划》就已经制定了三个阶段三步走的战略,人工智能治理就是其中重要的内容。规划中明确提出了要关注人工智能的潜在风险、建设有效治理体系的任务。所以,过去这些年中国在人工智能发展过程中始终将治理体系建设放在非常重要的位置上。2019 年,国家人工智能治理专家委员会推出了《新一代人工智能治理原则》,其核心就是要发展负责任的人工智能,有序发展风险防控和治理体系。我们提出了 8 条原则,这些原则在很大层面上也是世界各个国家的共识。但中国的 8 条原则中有一个独特的创新,就是明确提出了“敏捷治理”的原则。这是因为,我们发现人工智能的技术发展步伐非常快,但治理体系建设要经过合理的程序,步伐要慢多了,很容易出现步调不一致的问题。“敏捷治理”就是应对这个问题的关键。这 8 条原则得到了国际同行的好评。总的来说,我们国家的人工智能治理在 2020 年后加快了步伐,出台了很多法律法规、各种指南、各种治理原则、规则等,包括去年发布的《全球人工智能治理倡议》。地方政府也有很多措施,涵盖多维度、多领域、多层次的整体规划和各个部门的任务,包括中央、地方,公共部门和私营部门等,形成了从企业自我规制到法律的一整套人工智能治理体系,并有各种工具配合,实现了多维共治、敏捷治理。最终我们希望形成有中国特色的由多元治理主体、多元治理工具和不同治理路径组合的人工智能治理框架。

总体来说,中国的人工智能有雄厚积累与先发优势,形成了推动人工智能发展的总体规划,在过去发展过程中也形成了自上而下和自下而上相结合的治理框架,人工智能技术也有非常广阔的应用场景。同时,中国人工智能发展未来也面临着一些挑战。首先是怎么样形成不同企业公平竞争的市场环境,包括民营企业、国有企业和外资企业、包括大中小企业等等,这种多元公平竞争的市场环境对人工智能领域发展至关重要。其次是产业生态问题,如何建立企业、资金、人才等多方面主体和多方面资源能够有效流通协调一致的产业生态。第三是治理问题,怎么形成可预期、包容审慎、敏捷有效的治理框架,为形成鼓励人工智能发展的市场环境和产业生态奠定制度基础。最后,就是怎么聚集全球顶尖人工智能人才,Open-AI 是全世界各国不同优秀人才聚集发展起来,人才多元化程度很高,中国在这方面需要加大开放力度。我们相信在各方面的共同努力下,中国人工智能领域能够抓住发展机遇,克服重重困难,迎接多方面的挑战,有效防控各种风险,让人工智能的发展为中国现代化建设服务,为世界和平发展服务。